Linux tc qdisc的使用案例 在linux下通过tc qdisc 很容易对rt延时、丢包、带宽进行控制,这样的话方便重现各种网络问题

延时 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 1. give packets from eth0 a delay of 2ms bash$ tc qdisc add dev eth0 root netem delay 2ms 2.change the delay to 300ms bash$ tc qdisc change dev eth0 root netem delay 3ms 3.display eth0 delay setting bash$ tc qdisc show dev eth0 4.stop the delay bash$ tc qdisc del dev eth0 root # corrupt The following rule corrupts 5% of the packets by introducing single bit error at a random offset in the packet: tc qdisc change dev eth0 root netem corrupt 5%

模拟网络丢包 1 tc qdisc add dev eth0 root netem loss 1%

指定ip 172.31.65.30延时17ms, 测试发现181和183这两句命令顺序无所谓。恢复正常:179行命令

1 2 3 4 5 179 tc qdisc del dev eth0 root 180 tc qdisc add dev eth0 root handle 1: prio 181 tc filter add dev eth0 parent 1:0 protocol ip pref 55 handle ::55 u32 match ip dst 172.31.65.30 flowid 2:1 182 tc qdisc ls 183 tc qdisc add dev eth0 parent 1:1 handle 2: netem delay 17ms

指定ip和端口延时 指定 eth0 网卡,来源 ip 是 10.0.1.1,目的端口是 3306 的访问延迟 20ms,上下浮动 2ms 100.100.146.3

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 # 指定 eth0 网卡,来源 ip 是 10.0.1.1,目的端口是 3306 的访问延迟 20ms,上下浮动 2ms tc qdisc add dev eth0 root handle 1: prio bands 4 tc qdisc add dev eth0 parent 1:4 handle 40: netem delay 5ms 30ms tc filter add dev eth0 parent 1: protocol ip prio 4 basic match "cmp(u16 at 2 layer transport eq 80) and cmp(u8 at 16 layer network eq 100) and cmp(u8 at 17 layer network eq 100) and cmp(u8 at 18 layer network eq 146) and cmp(u8 at 19 layer network eq 3)" flowid 1:4 tc filter add dev eth0 parent 1: protocol ip prio 4 basic match "cmp(u8 at 16 layer network eq 100) and cmp(u8 at 17 layer network eq 100) and cmp(u8 at 18 layer network eq 61) and cmp(u8 at 19 layer network eq 88)" flowid 1:4 # 删除过滤 sudo tc filter del dev eth0 parent 1: prio 4 basic sudo tc qdisc del dev eth0 root

0 layer 代表 sport

指定端口34001上,延时5ms 1 2 3 tc qdisc add dev eth0 root handle 1: prio tc qdisc add dev eth0 parent 1:3 handle 30: netem delay 5ms tc filter add dev eth0 protocol ip parent 1:0 u32 match ip sport 34001 0xffff flowid 1:3

控制网卡的带宽、延时、乱序、丢包 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 sudo tc qdisc add dev bond0 root handle 1: netem delay 10ms reorder 25% 50% loss 0.2% sudo tc qdisc add dev bond0 parent 1: handle 2: tbf rate 1mbit burst 32kbit latency 10ms /sbin/tc qdisc add dev bond0 root tbf rate 500kbit latency 50ms burst 15kb // 同时模拟20Mbps带宽,50msRTT和0.1%丢包率 # tc qdisc add dev bond0 root handle 1:0 tbf rate 20mbit burst 10kb limit 300000 # tc qdisc add dev bond0 parent 1:0 handle 10:0 netem delay 50ms loss 0.1 limit 300000 tc qdisc change dev eth0 root netem reorder 50% gap 3 delay 1ms tc qdisc change dev eth0 root netem delay 1ms reorder 15% //在eth0上设置一个tbf队列,网络带宽为200kbit,延迟10ms以内,超出的包会被drop掉,缓冲区为1540个字节 sudo /sbin/tc qdisc add dev eth0 root tbf rate 200kbit latency 10ms burst 15kb sudo /sbin/tc qdisc ls dev eth0

在eth0上设置一个tbf队列,网络带宽为200kbit,延迟10ms以内,超出的包会被drop掉,缓冲区为1540个字节

rate表示令牌的产生速率, sustained maximum rate packets with higher latency get dropped

tbf: use the token buffer filter to manipulate traffic rates

限制10MB,排队等待超过100ms就触发丢包,只限制了出去的流量,没有限制进来的流量:

1 2 3 4 5 tc qdisc ls dev eth0 // 查看eth0上的队列规则 sudo tc qdisc add dev eth0 root tbf rate 80mbit burst 1mbit latency 100ms //限制80MB sudo tc qdisc add dev eth0 root tbf rate 80mbps burst 1mbps latency 100ms

乱序 1 2 3 1001 [2024-08-08 15:12:01] sudo tc qdisc add dev bond0 root handle 1: prio 1004 [2024-08-08 15:12:44] sudo tc filter add dev bond0 parent 1: protocol ip prio 1 u32 match ip dst 1.2.3.7 flowid 1:1 1005 [2024-08-08 15:13:17] tc qdisc add dev bond0 parent 1:1 handle 10: netem delay 10ms reorder 5% 10%

两地三中心模拟 针对不同的ip地址可以限制不同的带宽和网络延时,htb较prio多了一个带宽控制

通过htb 只限制带宽和延时

1 2 3 4 5 6 7 8 9 10 11 12 13 14 //对10.0.3.228、229延时1ms,对 10.0.3.232延时30ms 两地三中心限制延时和带宽 tc qdisc add dev eth0 root handle 1: htb tc class add dev eth0 parent 1: classid 1:1 htb rate 600Gbps tc filter add dev eth0 parent 1: protocol ip prio 1 u32 flowid 1:1 match ip dst 10.0.3.228 tc qdisc add dev eth0 parent 1:1 handle 10: netem delay 1ms tc class add dev eth0 parent 1: classid 1:2 htb rate 600Gbps tc filter add dev eth0 parent 1: protocol ip prio 1 u32 flowid 1:2 match ip dst 10.0.3.229 tc qdisc add dev eth0 parent 1:2 handle 20: netem delay 1ms tc class add dev eth0 parent 1: classid 1:3 htb rate 600Gbps tc filter add dev eth0 parent 1: protocol ip prio 1 u32 flowid 1:3 match ip dst 10.0.3.232 tc qdisc add dev eth0 parent 1:3 handle 30: netem delay 30ms

通过prio 只限制延时

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 //两地三中心限制不同的延时,htb 才可以加带宽限制 tc qdisc add dev eth0 root handle 1: prio //flowid 指定的是流量要去往的目标队列 //10.0.3.228/10.0.3.229 延时1ms tc filter add dev eth0 parent 1: protocol ip prio 1 u32 flowid 1:1 match ip dst 10.0.3.228/31 tc qdisc add dev eth0 parent 1:1 handle 10: netem delay 1ms //以上两行可以改成如下三行单独为 10.0.3.228 和 10.0.3.229 添加延时 1ms tc filter add dev eth0 parent 1: protocol ip prio 1 u32 flowid 1:1 match ip dst 10.0.3.228 tc filter add dev eth0 parent 1: protocol ip prio 1 u32 flowid 1:1 match ip dst 10.0.3.229 tc qdisc add dev eth0 parent 1:1 handle 10: netem delay 1ms //表示多条 filter 命中的流量都走这条 qdisc 规则 tc filter add dev eth0 parent 1: protocol ip prio 1 u32 flowid 1:2 match ip dst 10.0.3.232 tc qdisc add dev eth0 parent 1:2 handle 20: netem delay 30ms

对多个 ip 进行不同的时延控制:

1 2 3 4 5 6 7 8 9 10 tc qdisc add dev bond0 root handle 1: prio tc qdisc add dev bond0 parent 1:1 handle 10: netem delay 30ms tc filter add dev bond0 protocol ip parent 1:0 prio 1 u32 match ip dst 100.1.2.3 flowid 1:1 tc qdisc add dev bond0 parent 1:2 handle 20: netem delay 30ms tc filter add dev bond0 protocol ip parent 1:0 prio 1 u32 match ip dst 11.1.2.3 flowid 1:2 //查看 tc qdisc show dev bond0 tc filter show dev bond0

QDisc(排队规则)是queueing discipline的简写,它是理解流量控制(traffic control)的基础。无论何时,内核如果需要通过某个网络接口发送数据包,它都需要按照为这个接口配置的qdisc(排队规则)把数据包加入队列。然后,内核会尽可能多地从qdisc里面取出数据包,把它们交给网络适配器驱动模块。最简单的QDisc是pfifo它不对进入的数据包做任何的处理,数据包采用先入先出的方式通过队列。不过,它会保存网络接口一时无法处理的数据包。

一个网络接口上如果没有设置QDisc,pfifo_fast就作为缺省的QDisc。

CLASSFUL QDISC(分类QDisc),可分类的qdisc包括:

CBQ: CBQ是Class Based Queueing(基于类别排队)的缩写。它实现了一个丰富的连接共享类别结构,既有限制(shaping)带宽的能力,也具有带宽优先级管理的能力。带宽限制是通过计算连接的空闲时间完成的。空闲时间的计算标准是数据包离队事件的频率和下层连接(数据链路层)的带宽。

HTB: HTB是Hierarchy Token Bucket的缩写。通过在实践基础上的改进,它实现了一个丰富的连接共享类别体系。使用HTB可以很容易地保证每个类别的带宽,它也允许特定的类可以突破带宽上限,占用别的类的带宽。HTB可以通过TBF(Token Bucket Filter)实现带宽限制,也能够划分类别的优先级。

PRIO: PRIO QDisc 不能限制带宽,因为属于不同类别的数据包是顺序离队的。使用PRIO QDisc可以很容易对流量进行优先级管理,只有属于高优先级类别的数据包全部发送完毕,才会发送属于低优先级类别的数据包。为了方便管理,需要使用iptables或者ipchains处理数据包的服务类型(Type Of Service,ToS)。

htb分类 qdisc tbf 能对流量无差别控制,htb 可以进一步进行更精细的控制

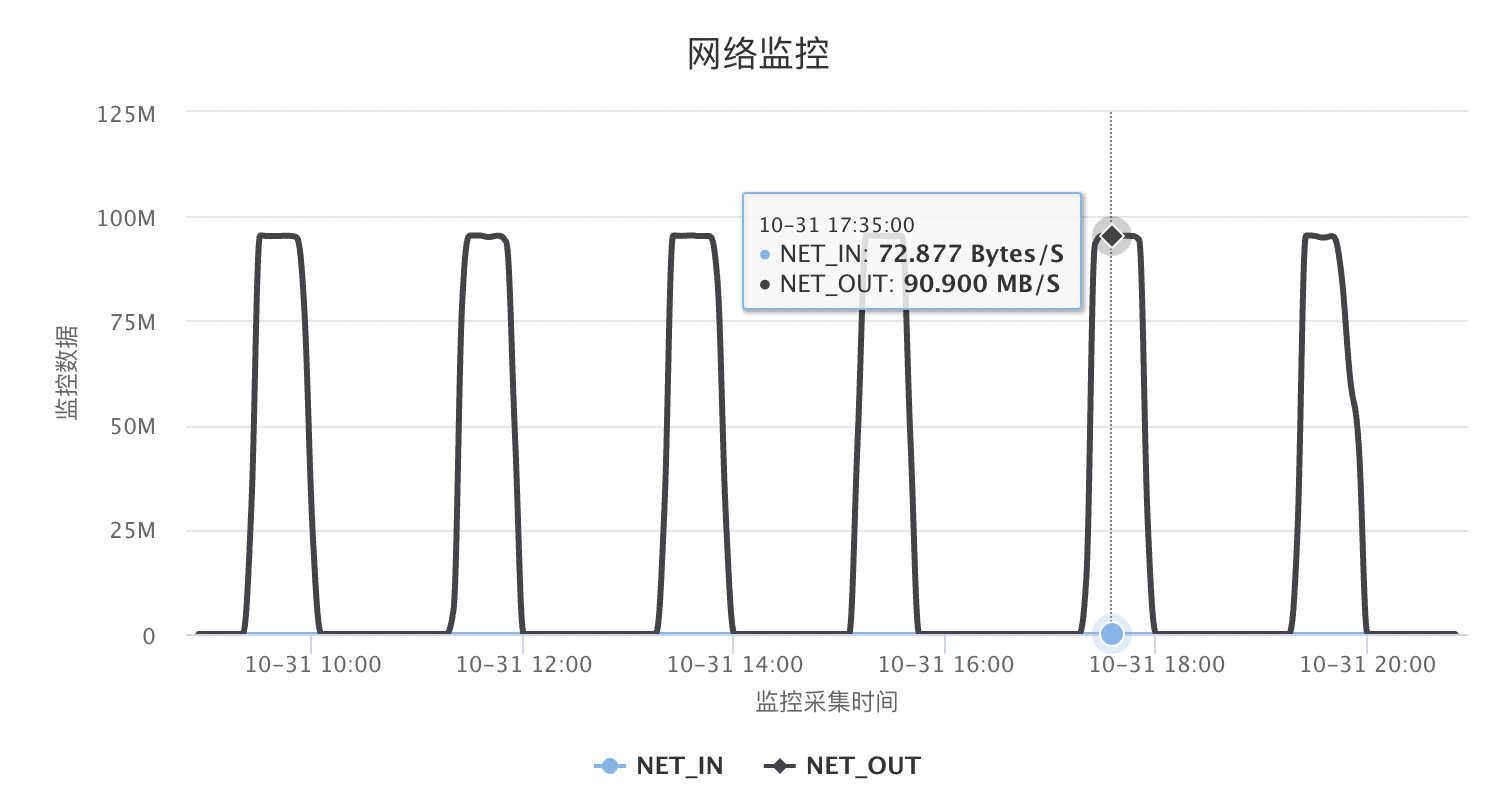

针对IP、端口限速案例 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 $ cat qdisc_bw.sh# !/bin/bash # 针对不同的ip进行限速 # 清空原有规则 tc qdisc del dev eth0 root # 创建根序列 tc qdisc add dev eth0 root handle 1: htb default 1 # 创建一个主分类绑定所有带宽资源(60M) tc class add dev eth0 parent 1:0 classid 1:1 htb rate 60Mbps burst 15k # 到这里可以使用了,整机速度限制到了60M # 创建子分类,ceil表示最大带宽 tc class add dev eth0 parent 1:1 classid 1:10 htb rate 2Mbps ceil 1Mbps burst 15k tc class add dev eth0 parent 1:1 classid 1:20 htb rate 20Mbps ceil 30Mbps burst 15k # 为了避免一个会话永占带宽,添加随即公平队列sfq. # perturb:是多少秒后重新配置一次散列算法,默认为10秒 # sfq,他可以防止一个段内的一个ip占用整个带宽 tc qdisc add dev eth0 parent 1:10 handle 10: sfq perturb 10 tc qdisc add dev eth0 parent 1:20 handle 20: sfq perturb 10 # 创建过滤器 # 对所有ip限速到1Mbps tc filter add dev eth0 protocol ip parent 1:0 prio 2 u32 match ip dst 0.0.0.0/0 flowid 1:10 # 对10.0.186.140限速在30Mbps tc filter add dev eth0 protocol ip parent 1:0 prio 1 u32 match ip dst 10.0.186.140 flowid 1:20 # 对端口进行filter限流 # tc filter add dev eth0 protocol ip parent 1:0 prio 1 u32 match ip sport 22 flowid 1:10 # 查看以上规则 sudo tc class show dev eth0 sudo tc filter show dev eth0

限流100MB后的实际监控效果

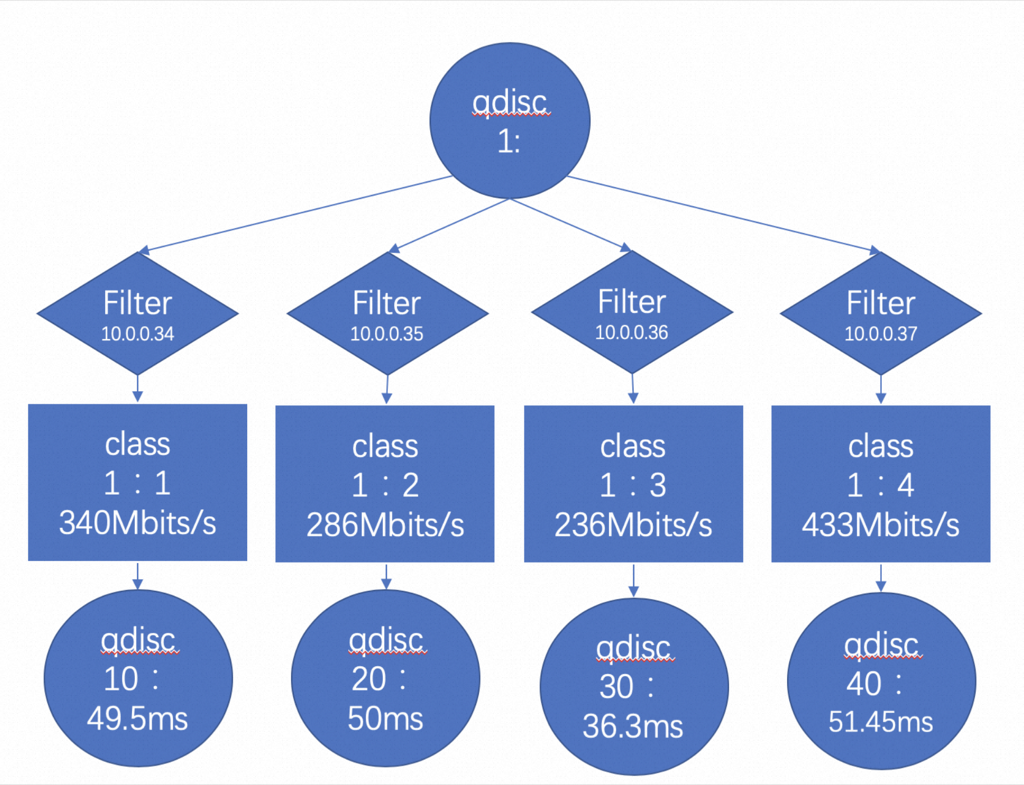

tc qdisc 示例 通过 Linux tc filter/qdisc 的代码来对 10.0.3.228/229/230/231 这四个 ip 分别增加 delay1/2/3/4 ms,带宽限制在 1Mb/2Mb/4Mb/8Mb

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 # 1. 首先在网卡上添加一个根队列规程(qdisc) tc qdisc add dev eth0 root handle 1: htb default 10 # 2. 创建主类 tc class add dev eth0 parent 1: classid 1:1 htb rate 100mbit # 3. 为每个 IP 创建子类并设置带宽 tc class add dev eth0 parent 1:1 classid 1:10 htb rate 1mbit tc class add dev eth0 parent 1:1 classid 1:20 htb rate 2mbit tc class add dev eth0 parent 1:1 classid 1:30 htb rate 4mbit tc class add dev eth0 parent 1:1 classid 1:40 htb rate 8mbit # 4. 为每个类添加延迟 tc qdisc add dev eth0 parent 1:10 handle 10: netem delay 1ms tc qdisc add dev eth0 parent 1:20 handle 20: netem delay 2ms tc qdisc add dev eth0 parent 1:30 handle 30: netem delay 3ms tc qdisc add dev eth0 parent 1:40 handle 40: netem delay 4ms # 5. 添加过滤规则,将不同 IP 的流量导向不同的类 tc filter add dev eth0 protocol ip parent 1: prio 1 u32 match ip dst 10.0.3.228/32 flowid 1:10 tc filter add dev eth0 protocol ip parent 1: prio 1 u32 match ip dst 10.0.3.229/32 flowid 1:20 tc filter add dev eth0 protocol ip parent 1: prio 1 u32 match ip dst 10.0.3.230/32 flowid 1:30 tc filter add dev eth0 protocol ip parent 1: prio 1 u32 match ip dst 10.0.3.231/32 flowid 1:40

以上代码对应的层级结构:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 eth0 [root] └── 1: htb (根队列规程) └── 1:1 htb [rate 100mbit] (主类) ├── 1:10 htb [rate 1mbit] (子类) │ └── 10: netem [delay 1ms] │ └── filter: dst 10.0.3.228/32 │ ├── 1:20 htb [rate 2mbit] (子类) │ └── 20: netem [delay 2ms] │ └── filter: dst 10.0.3.229/32 │ ├── 1:30 htb [rate 4mbit] (子类) │ └── 30: netem [delay 3ms] │ └── filter: dst 10.0.3.230/32 │ └── 1:40 htb [rate 8mbit] (子类) └── 40: netem [delay 4ms] └── filter: dst 10.0.3.231/32

docker 中使用 tc docker里无法使用的bug 可以参考 https://bugzilla.redhat.com/show_bug.cgi?id=1152231,解决方法就是升级tc版本,tc qdisc add 时加上direct_qlen参数

场景: 故障注入的docker: 10.1.1.149

10.1.1.149上会模拟各种网络故障,但是中控机到该docker的连接需要不受影响

DEVICE_NAME=eth0

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 # 根规则,direct_qlen 1000必须加,否则在docker的虚拟网络跑不了 tc qdisc add dev ${DEVICE_NAME} root handle 1: htb default 1024 direct_qlen 1000 # 建立两个类继承root tc class add dev ${DEVICE_NAME} parent 1:0 classid 1:1 htb rate 10000mbit tc class add dev ${DEVICE_NAME} parent 1:0 classid 1:2 htb rate 10000mbit #新版本的tc在filter设置完后,所有网络都会断,类似黑名单,需要加qdisc才能恢复, 所以先让两个通道都能跑 # 队列采用公平的调度算法,保证网络通畅,perturb参数是每隔10秒换一次hash,进一步保障平均 tc qdisc add dev ${DEVICE_NAME} parent 1:1 sfq perturb 10 tc qdisc add dev ${DEVICE_NAME} parent 1:2 sfq perturb 10 # 加过滤规则 #1.队列1是和跳板机交互的网络,需要保持通畅 tc filter add dev ${DEVICE_NAME} protocol ip parent 1: prio 10 u32 match ip dst 10.0.0.200/32 flowid 1:1 #2.其他所有主机走队列2,实现网络模拟 tc filter add dev ${DEVICE_NAME} protocol ip parent 1: prio 10 u32 match ip dst 0.0.0.0/0 flowid 1:2 #队列2 开始网络模拟 #该命令将${DEVICE_NAME}网卡的耗时随机delay 100ms,延迟的尖刺在标准值的正负30ms, 最后的百分比数字是尖刺的相关系数 # 这边用replace是因为之前已经用add加过规则了 tc qdisc replace dev ${DEVICE_NAME} parent 1:2 netem delay 100ms 30ms 25% #该命令将 ${DEVICE_NAME} 网卡的传输设置为随机丢掉10%的数据包, 成功率为50% tc qdisc replace dev ${DEVICE_NAME} parent 1:2 netem loss 10% 50% #该命令将 ${DEVICE_NAME} 网卡的传输设置为随机产生10%的重复数据包。 tc qdisc replace dev ${DEVICE_NAME} parent 1:2 netem duplicate 10% #该命令将 ${DEVICE_NAME} 网卡的传输设置为:有25%的数据包会被立即发送,其他的延迟10ms,相关性是10%,产生乱序 tc qdisc replace dev ${DEVICE_NAME} parent 1:2 netem delay 10ms reorder 25% 10% #该命令将 ${DEVICE_NAME} 网卡的传输设置为随机产生9%的损坏的数据包 tc qdisc replace dev ${DEVICE_NAME} parent 1:2 netem corrupt 9%

恢复网络

1 2 3 4 5 6 7 8 9 10 11 12 13 14 #让网络恢复正常 tc qdisc replace dev ${DEVICE_NAME} parent 1:2 sfq perturb 10 # =================== 查看规则 ====================== tc filter show dev ${DEVICE_NAME} tc class show dev ${DEVICE_NAME} tc qdisc show dev ${DEVICE_NAME} #====================== 清理 ====================== tc filter delete dev ${DEVICE_NAME} parent 1:0 protocol ip pref 10 tc qdisc del dev ${DEVICE_NAME} parent 1:2 netem tc class del dev ${DEVICE_NAME} parent 1:0 classid 1:2 tc class del dev ${DEVICE_NAME} parent 1:0 classid 1:1 tc qdisc del dev ${DEVICE_NAME} root handle 1

报错 1 2 3 4 5 6 7 [root@iZj6c7oe1q6a7lz27e3m20Z ~]# tc qdisc show dev eth0 qdisc prio 1: root refcnt 9 bands 3 priomap 1 2 2 2 1 2 0 0 1 1 1 1 1 1 1 1 [root@iZj6c7oe1q6a7lz27e3m20Z ~]# tc qdisc add dev eth0 parent 1:3 handle 30: netem delay 5ms Error: Specified qdisc kind is unknown. #tc qdisc add dev eth0 root netem delay 2ms Error: Specified qdisc kind is unknown.

内核没有加载 sch_netem 模块导致,安装:

1 2 3 sudo yum install -y kernel-modules-extra-`uname -r` 然后 modprobe sch_netem

sch_netem 内核模块加载后就正常了

参考资料 https://netbeez.net/blog/how-to-use-the-linux-traffic-control/

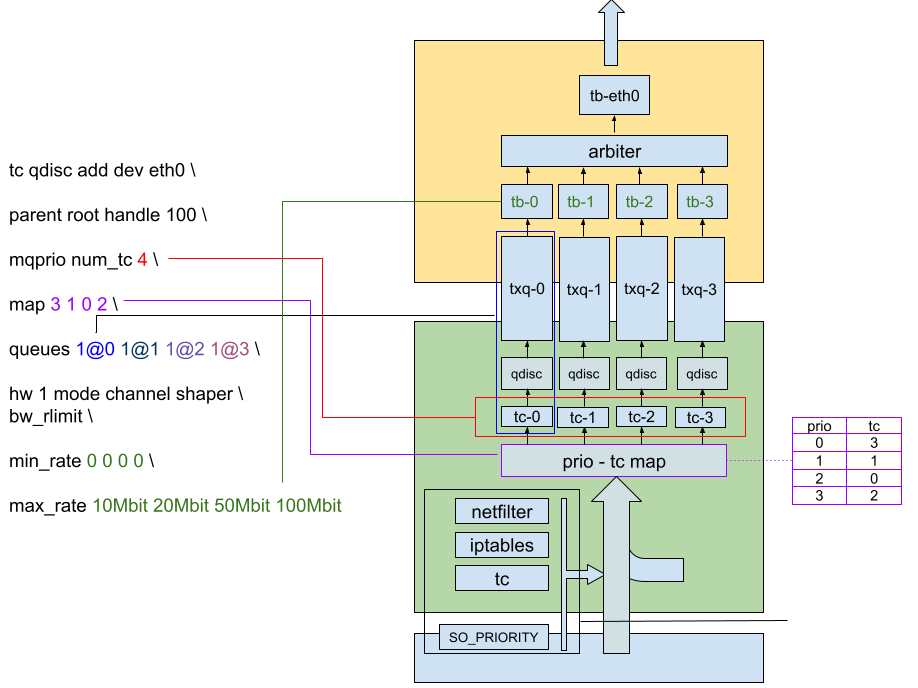

https://bootlin.com/blog/multi-queue-improvements-in-linux-kernel-ethernet-mvneta/